في خطوة أثارت موجة من الجدل، أطلقت شركة OpenAI وكيلاً جديداً للذكاء الاصطناعي ضمن منصة "شات جي بي تي"، قادراً على تنفيذ مهام معقدة مثل جمع البيانات، إنشاء جداول، حجز رحلات، وتحضير عروض تقديمية... بل وربما، المساعدة في صنع أسلحة بيولوجية.

هذا الوكيل الجديد، الذي يُمثل أحد أكثر التطويرات تقدماً وخطورة في مجال الذكاء الاصطناعي، صُنف لأول مرة من قبل الشركة على أنه يتمتع بقدرة "عالية" على التسبب في مخاطر بيولوجية، مما يعني إمكانية مساعدته لغير المختصين في تنفيذ تهديدات كيميائية أو بيولوجية.

وقالت الشركة في إطار تأهبها لمثل هذه التهديدات، إن هذه القدرات تتطلب تدابير حماية مشددة، تشمل رفض أي أوامر مشبوهة، وتحويل الطلبات الحساسة لمراجعة بشرية، إضافة إلى مراقبة مستمرة لسلوك المستخدمين.

وصرّح بواز باراك، من فريق "OpenAI" الفني، قائلاً: "قد يعتقد البعض أن الخطر مبالغ فيه، لكن تقييماتنا تؤكد أن الخطر حقيقي. كان يمكن العثور على هذه المعلومات في 2024، أما اليوم فالنموذج يقدم توجيهات قريبة من نصائح الخبراء".

من جهتها، أكدت الباحثة في السلامة بالشركة، كيرين جو، أنه رغم عدم وجود دليل على استخدام النموذج حتى الآن في أعمال ضارة، فإن الشركة اختارت نهجاً وقائياً مشدداً، خاصة في ظل صعوبة السيطرة على المعرفة المطلوبة لصنع تهديد بيولوجي.

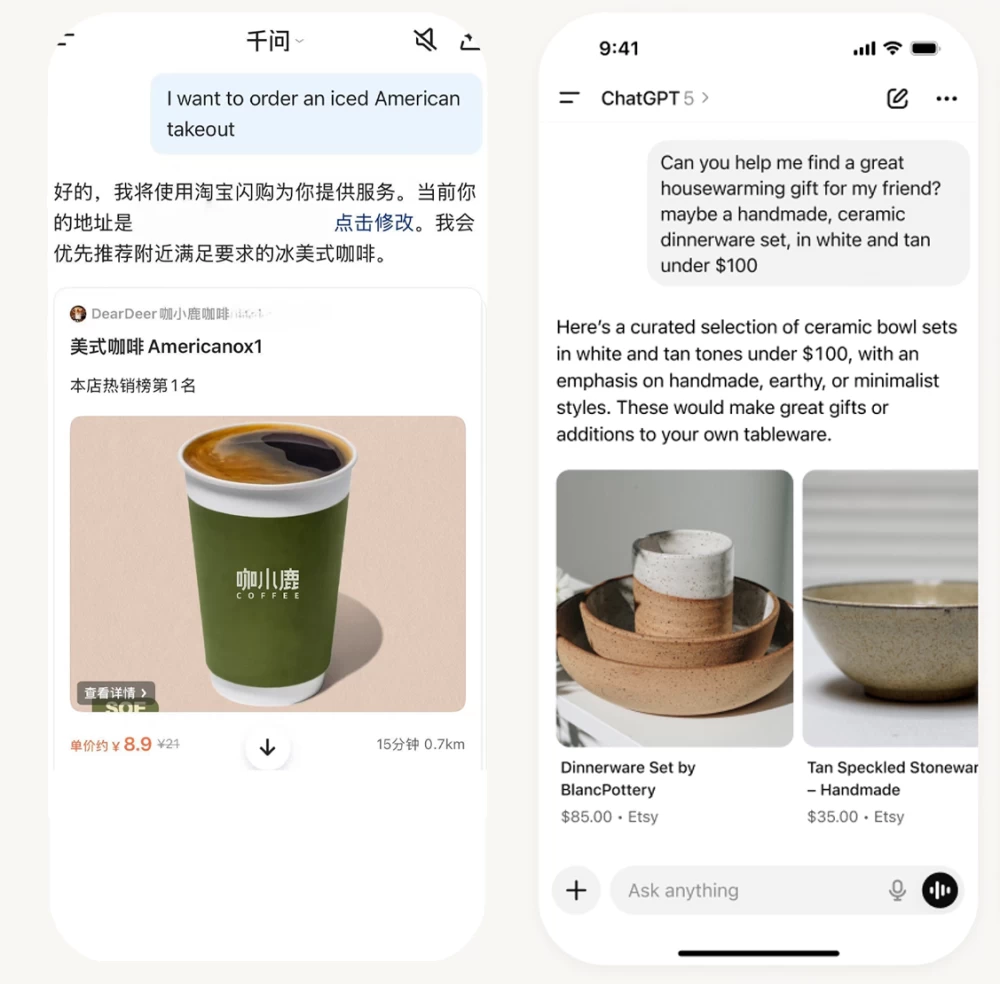

يُشار إلى أن إطلاق هذا الوكيل الجديد يأتي في سباق محتدم بين كبرى شركات التقنية مثل "غوغل" و"أنثروبيك" لبناء وكلاء ذكيين قادرين على إدارة المهام الرقمية تلقائياً. ورغم الفرص التجارية الكبيرة، يعترف الخبراء بأن الاستقلالية العالية لهذه النماذج تعني ارتفاعاً حتمياً في المخاطر.

وفي ظل غياب مواد نادرة كما هو الحال في الأسلحة النووية، تحذّر "OpenAI" من أن سهولة الوصول للمعرفة عبر هذه النماذج قد تُعزز من قدرة أي شخص، مهما كان مستواه العلمي، على التسبب في أذى كبير.