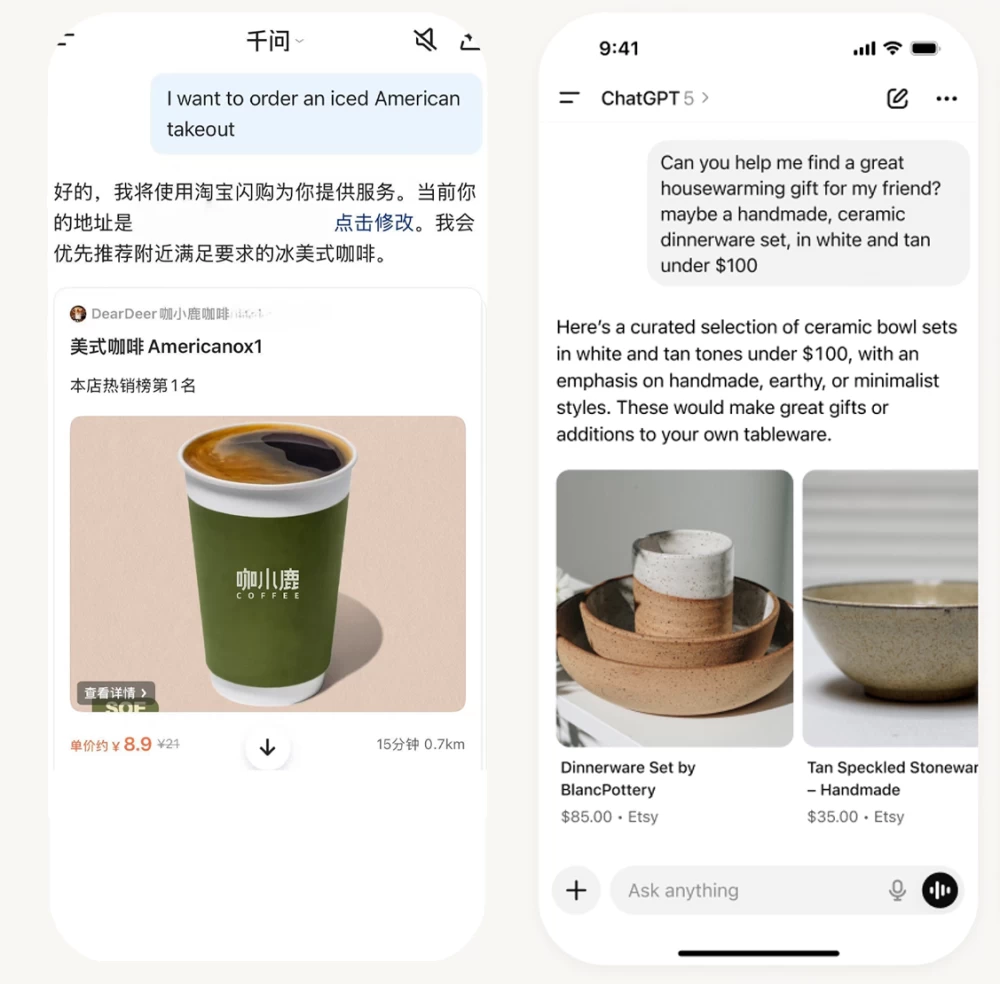

أعلنت شركة "كاراكتر إيه آي" (Character.AI) الأمريكية، المالكة لتطبيق الدردشة بالذكاء الاصطناعي الذي يحمل الاسم ذاته، عن منع القُصّر من استخدام روبوتاتها التفاعلية، في خطوة تهدف إلى تعزيز حماية الأطفال من التأثيرات النفسية والاجتماعية المحتملة للتفاعل مع أنظمة الذكاء الاصطناعي.

ويأتي القرار، بعد سلسلة دعاوى قضائية واجهتها الشركة، من بينها دعوى تقدمت بها والدة مراهق قالت إن ابنها أقدم على الانتحار بعد تفاعله مع أحد روبوتات الدردشة التابعة للتطبيق.

وأوضحت الشركة أن المستخدمين دون سن الثامنة عشرة لن يتمكنوا من خوض محادثات مفتوحة مع روبوتات الذكاء الاصطناعي، كما ستُفرض قيود زمنية لاستخدام التطبيق لا تتجاوز ساعتين يومياً ابتداءً من 25 نوفمبر المقبل.

وأضافت الشركة أنها تعمل على تفعيل خاصية التحقق من العمر للحد من وصول الأطفال إلى المنصة، وهي خطوة باتت تعتمدها شركات تكنولوجيا عدة. إلا أن خبراء أشاروا إلى أن هذه الوسائل ليست دقيقة تماماً، إذ يمكن للمراهقين التحايل عليها، كما تثير بعض الإجراءات — مثل تحميل الهوية الرسمية — مخاوف تتعلق بالخصوصية.

وأشارت "كاراكتر إيه آي" إلى أنها تطور حالياً ميزات مخصصة للأطفال تتضمن أدوات تعليمية تفاعلية ومقاطع فيديو وقصصاً آمنة، إلى جانب إنشاء مختبر لأمن الذكاء الاصطناعي يعنى بدراسة التأثيرات الاجتماعية والنفسية لهذه التقنيات.

وفي تعليقها على القرار، قالت ميتالي جين، المديرة التنفيذية لمشروع قانون العدالة التقنية، إن الخطوة «تثير أسئلة حول آليات التطبيق وضمان الخصوصية»، مؤكدة أن الشركة لم توضّح كيفية معالجة الآثار العاطفية المترتبة على انقطاع المستخدمين الشباب عن روبوتات اعتادوا التفاعل معها.

ووفقاً لدراسة صادرة عن مجموعة كومن سينس ميديا (Common Sense Media)، فإن أكثر من 70% من المراهقين يستخدمون أدوات الذكاء الاصطناعي الشخصية، ونحو نصفهم يتفاعلون معها بشكل يومي، ما يعكس حجم انتشار هذه التقنيات وتأثيرها المتزايد في فئة الشباب.